| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- Manmohan #UnconstrainedComputerVision

- cornernet #simple #다음은centernet #hourglass생명력이란

- ICCV19 #Real-World #FaceRecognition

- coco

- IvanLaptev

- 정리용 #하나씩읽고있음 #많기도많네 #내가찾는바로그논문은어디에

- vit

- centernet

- hourglass

- CVPR

- objectdetector

- Realtime

- XiaomingLiu #PersonIdentification

- DeepDoubleDescent #OpenAI #어려워

- np-hard

- POSE ESTIMATION

- Transformer #classification #SOTA #Google

- Today

- Total

HyperML

Deep Double Descent 본문

Deep Double Descent

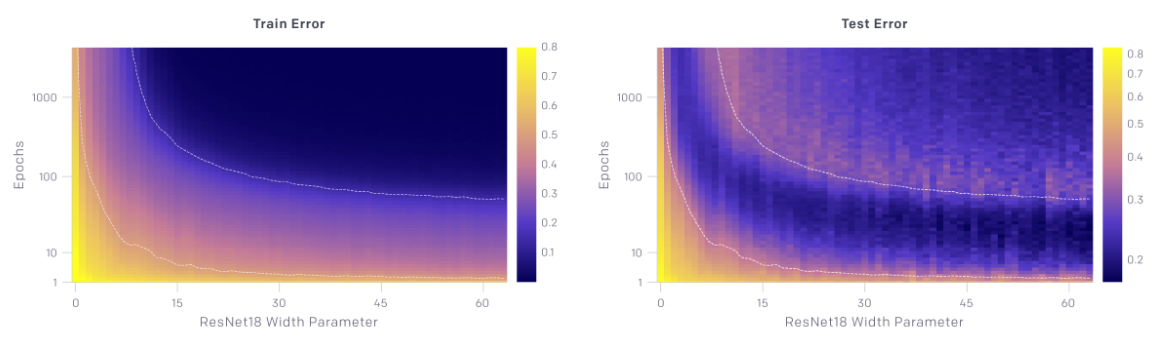

We show that the double descent phenomenon occurs in CNNs, ResNets, and transformers: performance first improves, then gets worse, and then improves again with increasing model size, data size, or training time. This effect is often avoided through careful

openai.com

며칠전 커뮤니티에서 위 현상을 다룬 포스팅들이 올라와서 잠깐 해당 내용을 확인해보았다.

제목인 Deep Double Descent를 다룬 것인데, 이 현상은 별도의 regularization을 쓰지 않은 CNN, Resnet, Transformer 네트워크에서 발견된다고 한다.

아쉽게도, 원인은 아직 규명되지 않았고, 이것과 관련된 인자만 몇가지가 확인되었다고 한다.

포스팅에서 설명하고자 하는 부분의 머신러닝에 대한 이해가 충분하지 않으므로 대체로 번역만 하고, 의견은 배제하려고 하였다.

1. 더 큰 모델이 (성능이) 더 나빠지는 구간이 있다

위 차트에서 보면 resnet모델 width크기가 커질 수록 test error가 커지는 구간(ciritical regime)이 존재한다는 것을 알 수 있다. 이 구간에서의 train error 추세와 대비된다.

최적화 알고리즘(SGD같은..), 학습 샘플수, 라벨노이즈에 따라서 interpolation threshold와 test error peak가 변화되는 것이 확인되었다.

특히 의도적으로 라벨노이즈를 추가했을 때 이 현상이 증폭되어 잘 관찰되었다.

2. 더 많은 데이터를 투입해도 효과가 더 떨어지는 구간이 있다

위는 트랜스포머를 라벨노이즈 없이 학습했을때의 차트인데, 18k trainset의 test ce loss가 더 높은 구간이 존재한다.

더 많은 학습데이터를 투입한 경우에 더 큰 모델이 요구되는 것은 사실인데, 그러면 위 1번의 interpolation threshold(와 test peak)가 우측으로 이동한다.

3. 더 오래 학습한 경우에 오버피팅이 뒤집어지는 구간이 존재한다

인자가 2개(epochs, width params)에 보고자 하는 값이 error(색상)이므로 주의 깊게 봐야 한다.

주목할 곳은 우측 차트인데, 대략 7 이상의 width parameter 에서 epoch을 진행시켜 위로 이동하다 보면 train error와 달리 test error가 어두운 보라색이다가 다시 밝은 보라색으로 변경되는 현상이 발생한다.

즉, epoch이 진행됨에 따라 test error가 지속적으로 감소하지 않고 증가했다가 감소하는 구간이 존재한다. (epoch-wise double descent)

마무리

일반적으로 test error peak은 모델이 해당 학습셋을 거의 fit 시킬 수 없을 때 시스템적으로 나타난다고 한다.

위의 현상이 나타날 조건에 있는 모델들에겐 하나의 학습 모델만이 fit을 제대로 시켜줄 수 있으며 약간의 라벨 노이즈만 존재해도 전체적인 구조가 무너진다고 한다. 즉, 학습셋을 잘 보간하고 테스트셋에서 잘 성능을 발휘할 모델은 없다. (여전히 어려운 말이다)

그러나 아예 파라미터수가 많은 모델을 사용할 경우, 이러한 학습셋을 잘 fit할 수 있는 많은 모델이 존재한다. 게다가 SGD의 암묵적인 바이어스가 아직 이해할수는 없는 이유로 이런 경우에도 모델을 잘 학습한다.

'논문읽기' 카테고리의 다른 글

| An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale (ViT) (0) | 2021.07.18 |

|---|---|

| RandAugment: Practical automated data augmentation with a reduced search space (google brain) (0) | 2020.05.29 |

| Pose estimation 정리 링크 (0) | 2019.10.22 |

| GAN link 모음 (0) | 2019.09.28 |

| [CVPR16]Thin-Slicing for Pose: Learning to Understand Pose without Explicit Pose Estimation (0) | 2019.09.27 |